Исследование

«Жизнь в прямом эфире»

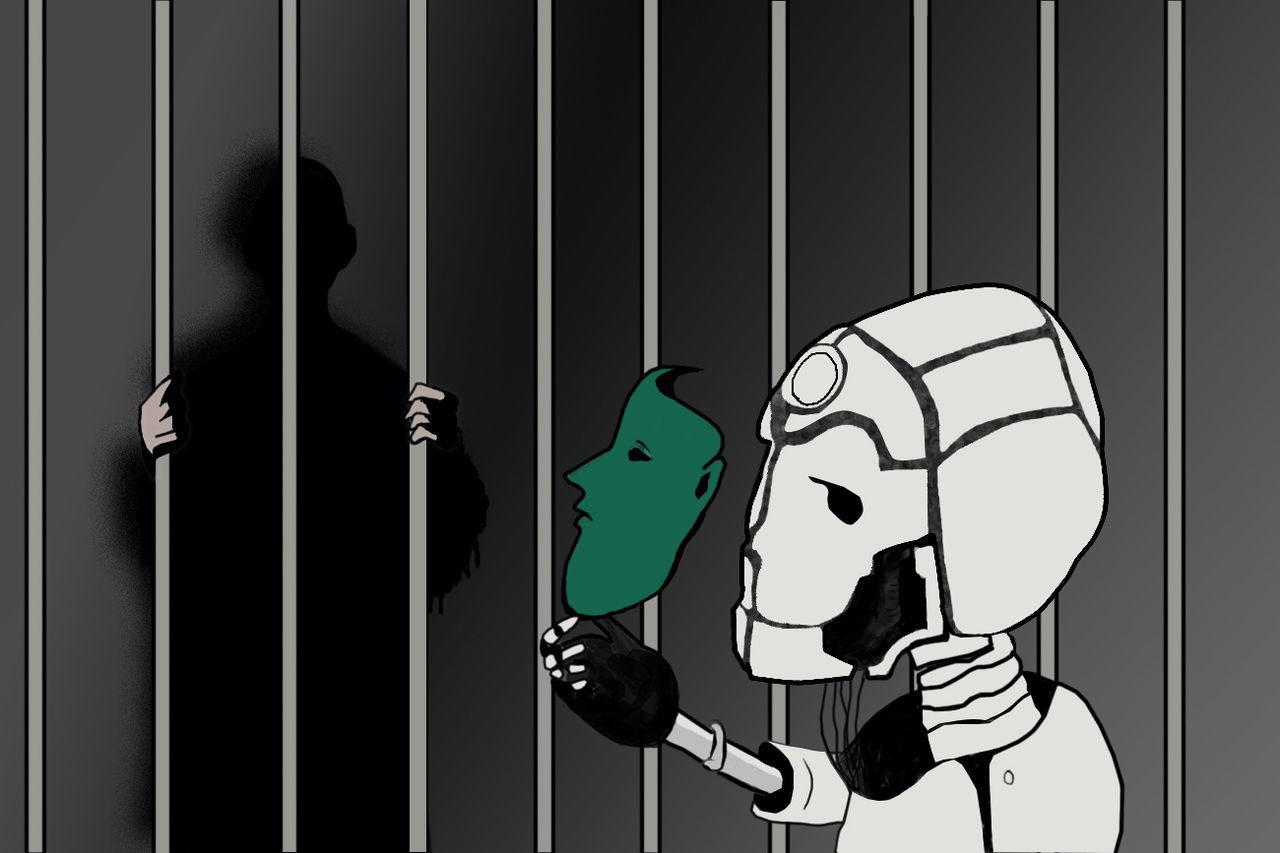

Машинное обучение, большие данные и искусственный интеллект — эти темы у всех на слуху. Однако мало кто задумывается о спорных последствиях применений технологий за пределами маркетинговых стратегий. Мы уже пытались разобраться, что такое машинное творчество, и рассказывали об основных проблемах эры сбора данных. Теперь мы попытаемся разобраться, что такое машинное обучение, как техника заменит человека на большинстве видов работ — и почему новый порядок может оказаться настоящей антиутопией.

I СБОР ДАННЫХ

Сбор данных по праву называется онлайн-слежкой. «Гугл», «Фейсбук», «ВКонтакте» и многие другие службы непрерывно строят профили пользователей из информации, которую те оставляют на страницах — публичных, приватных и даже неопубликованных («Фейсбук» проводил исследования о том, что пользователи чаще всего хотят написать, но стирают, не отправив). Это, естественно, не только беспокоит рядовых пользователей и правозащитные группы, но привлекает внимание законодателей. Каждый клик, комментарий, лайк, просмотр видео и то время, которое вы потратили на чтение поста в своей ленте, даже не кликая и не оставляя лайка, — всё будет записано, проанализировано и сложено в объёмный и подробный портрет, который затем будет использован для создания таргетированной рекламы. Для иллюстрации этого принципа разработано расширение DataSelfie, которое помогает визуализировать данные, отправляемые пользователями в «Фейсбук». Если одно простое расширение способно предсказать вашу религию, возраст и сексуальную ориентацию, представьте, на что способны штатные программисты «Фейсбука» и «ВКонтакте».

Одним из последствий глубокой персонализации поиска стало образование вокруг пользователя так называемого «пузыря фильтров». История ваших поисковых запросов, просмотры конкретных страниц и даже их частей влияют на то, что поисковая система покажет вам в следующий раз и что порекомендует: вас окружают контентом определённой тематики — которая с большей вероятностью вам понравится. Real Life Magazine описывает курьёзный случай: автор посмотрел на «Ютьюбе» видео из игры Dota 2, и на следующий день вся главная страница была в рекомендациях расистов из альт-райта (а иногда и откровенных нео-наци). Эта очевидная ошибка классификации интересов — хороший пример того, как работают фильтры в подобных рекомендательных системах. Стараясь увеличить время, которое пользователь проводит на сайте, ему «скармливают» то, что ему нравится или может понравиться, отгораживая от более широкого спектра мнений в уютном пузыре. Исследования показывают, что путь от известных ютьюберов до конспиролога Алекса Джонса не так долог, как кажется: по мере уточнения интересов пользователя рекомендации «Ютьюба» могут уводить во всё более радикально правый крен.

Сбор данных может использоваться и в далёких от задач маркетинга сферах. В Китае появилась идея внедрить в будущем универсальный рейтинг благонадёжности граждан, основанный на их истории покупок, комментариях в интернете, действиях друзей и так далее. А в Японии полгода назад одна из крупнейших японских страховых компаний заключила с IBM контракт на поставку системы Watson, которая умеет очень быстро отследить все персональные данные клиента, оценить риски и сформировать процентную ставку — а значит, впоследствии заменит большую часть нынешних работников страхования.

II ЧТО ТАКОЕ МАШИННОЕ ОБУЧЕНИЕ

Машинное обучение — это попытка машины найти закономерность между набором определённых свойств и заданным правильным ответом. Машина считается «обученной» тогда, когда она выводит из этого набора предметов и свойств закономерность. Эта закономерность называется моделью, а сам процесс вывода — тренировкой модели. Результат работы модели с данными напрямую зависит от того набора данных, который человек «скормил» модели при тренировке. Скорректировать такую модель в дальнейшем оказывается довольно сложно: этот процесс связан с долгой и затратной переподготовкой данных.

Из этого следует несколько выводов. Во-первых, машинное обучение очень плохо предсказывает или классифицирует то, что выходит за рамки модели. Стандартная практика в индустрии — выкидывать «примеры-аутсайдеры» уже на этапе тренировки: если нужно предсказать время пробега пяти километров по возрасту и любимому цвету, то придётся отбросить мировых чемпионов и любителей сверхредких цветов — потому что для установления связи выборка будет слишком маленькой. Во-вторых, если тренировочная выборка содержит определённые предрассудки, они, разумеется, напрямую отразятся на модели. Скажем, если согласно выборке люди определённого социального положения, или определённой национальности, или пола в среднем хуже выплачивают кредиты или хуже учатся, то их шансы получить кредит или стипендию снизятся уже только потому, что они являются частью определённой группы. Самое ужасное состоит в том, что даже если в законе запрещена дискриминация по определённым признакам — полу, вероисповеданию или сексуальной ориентации, то система может использовать так называемые прокси-свойства (любимый цвет, любимый праздник или просмотр всех сезонов «Хора»), которые хоть и не напрямую, но с высокой долей вероятности указывают на «те самые» признаки.

III МАШИННАЯ ДИСКРИМИНАЦИЯ

Компания «Убер» окружена скандалами с самого основания, и совсем недавно разразился ещё один: в некоторых городах США «Убер» был замечен в дискриминационной ценовой политике, когда одни и те же маршруты могут оказаться дороже на основании анализа платёжеспособсти клиента. Выходишь из бара в два часа ночи, заказываешь такси и, как обычно, получаешь полную цену перед поездкой — но она зависит не от количества километров, а от района, в котором ты живёшь, и твоей предрасположенности тратить больше денег в подвыпившем состоянии (установленной на основе истории твоих покупок). Учитывая, что «Убер» имеет огромное количество информации о своих клиентах и даже знает, едешь ли ты обратно со свидания на одну ночь, компания вполне может себе позволить выжать из клиента все наличествующие деньги с определённой степенью точности.

Очевидный пример предвзятости компьютерных алгоритмов — встроенный в них расизм, особенно в США. Издание ProPublica описывает несколько подобных случаев, когда чёрные подсудимые получали более высокие оценки при предсказании рецидива насильственных преступлений: восемнадцатилетняя чёрная девушка с четырьмя мелкими нарушениями получила оценку «восемь», а сорокавосьмилетний белый мужчина, отсидевший за два вооружённых ограбления и одну попытку вооружённого ограбления, оказался менее опасным для общества с оценкой «три». Производитель системы оценки рисков, компания Northpointe, использует для анализа сто тридцать семь вопросов, ответы на которые по большей части можно найти в деле обвиняемого — но на некоторые он должен ответить сам, в том числе: «Были ли ваши родители в тюрьме?» и «Употребляете ли вы наркотики?» Очевидно, что многие из этих вопросов тесно связаны с социально-экономическим статусом подозреваемого и приведут к плохим результатам для бедных и цветных. США в целом известны расизмом, в том числе судебной системы: чёрные, как правило получают более суровые приговоры, чем белые. Нет сомнения, что компьютерная модель будет принимать решения, соответствующие господствующему в обществе неравенству. Машина не может магическим образом вычислить и самостоятельно отменить предрассудки в системе принятия решений. «Мусор на входе — мусор на выходе», — любят повторять выпускники факультета компьютерных наук, и здесь эта поговорка применима как никогда. Кроме того, использование машинных систем оценки рисков размывает коллективную ответственность за подобные проявления расизма.

IV ОТВЕТСТВЕННОСТЬ

В США в некоторых муниципалитетах уже сейчас для определения уровня угрозы жизни полицейских используется анализ адреса вызова наряда — и на место происшествия по поводу жалобы на громкую музыку может приехать спецназ, а не обычный патруль, выбить дверь и пристрелить собаку просто потому, что система ошибочно выдала красный уровень опасности вместо зелёного или жёлтого. Компании, предоставляющие системы оценки рисков, не идут на контакт с активистами, которые призывают к открытию кода и большей ответственности за ложные срабатывания. Эрик Лумис, приговорённый к шести годам тюрьмы и пяти годам испытательного срока, не мог опротестовать оценку системы Compas, которая оценила его как опасного преступника, так как не знал алгоритма, который является интеллектуальной собственностью компании и защищён патентом. Тут важна даже не столько опасность Лумиса лично: подрывается сам принцип судебной работы, когда невозможно в принципе оспаривать неизвестно какие и непонятно как полученные аргументы обвинения. Подобные ненадёжные системы оценки рисков также используются в судах некоторых штатов для определения опасности для общества конкретных лиц. Независимые исследования показывают их абсолютную некомпетентность и пристрастность. Озабоченность этим также выразил и Департамент юстиции США, однако собственные исследования им пока проведены не были.

Российские технологические компании пока не добрались до судов. Частная слежка за гражданами для сбора данных, которые потом будут использованы для анализа, начинается с автомобилистов. Компания «Benish GPS» предлагает страховщикам и их клиентам делиться информацией о местоположении и стиле вождения машины, чтобы сократить страховые выплаты. Также были проекты по использованию данных интернет-счётчиков для расчёта кредитного рейтинга. Осторожней, возможно, вы сейчас находитесь на сайте для бедных людей — и кредита вам не видать.

Знаменитый стэнфордский тюремный эксперимент показал, что многие люди готовы пойти на ужасные вещи, если смогут переложить ответственность за свои действия на начальника. В дивном новом мире роль «несущих ответственность» могут исполнять машины. Люди и так очень склонны полагаться на технику (и использовать её в качестве отмазки — вспомним известный скетч Маленькой Британии «Компьютер говорит „нет“», где ленивая медсестра отказывает пациентам под надуманным предлогом). Использование машинного обучения может снимать ответственность с индивидуального исполнителя, который мог бы войти в положение человека, просящего о выдаче кредита или стипендии. При этом компании, предоставляющие системы машинного обучения, также не несут никакой ответственности: нет ни публичного доступа к коду, ни к тренировочным данным модели: мы не можем ни узнать принцип работы системы, ни исправить её недостатки, а значит, не можем подвергнуть сомнению её решения.

Безответственное отношение к оценивающим системам и их бесконтрольное распространение могут только поспособствовать снижению социальной мобильности и ужесточению уже существующих в обществе предрассудков, если компании, создающие системы, не будут активно бороться с необъективностью внутри себя. Но на это надежды мало:

«В некоторых ситуациях бизнес может позволить себе действия, которые были бы противозаконными, если бы ответственность на них не была перенесена с людей на „алгоритмы“. Причём данные, на основе которых происходит эта дискриминация, люди отдают добровольно, как раз чтобы её избежать. Это [согласие на получение и обработку данных] называется „предоставление лучших условий отдельным категориям клиентов“. Продавец не имеет права отказать покупателю в товаре или услуге — это противоречит законам о торговле в большинстве стран, а „антифрод-система“ может», — комментирует Алекс Смирнов, эксперт по информационной безопасности.

В начале 2017 года Американский союз защиты гражданских свобод (ACLU) опубликовал разбор дела, касавшегося уменьшения медицинских выплат по государственным страховкам Medicaid в штате Айдахо. Лимит страховых выплат для инвалидов пересматривается раз в год, и многие получившие тридцатипроцентное снижение суммы страхового покрытия обратились в ACLU за объяснениями. Выяснилось, что для расчёта страховки использовалась таблица в Excel. Компания отказалась объяснить принцип работы этого алгоритма, сославшись на коммерческую тайну. В конце концов суд постановил, что принцип работы должен быть открыт, после чего ACLU потратили 50 000 долларов на изучение формулы и пришли к неутешительным выводам.

Эрик Эппник, юридический директор ACLU в Айдахо: «Там всё пошло не так. Во-первых, данные для формулы были повреждены. Они использовали исторические данные для предсказания будущего, но две трети записей пришлось выбросить ещё на стадии подготовки из-за ошибок обработки данных и нестыковок. Так что они пытались предсказать нужды населения по ошибочным историческим записям — и то по небольшой их части. А у плохих данных — плохой результат. Во вторых, тестирование самого штата обнаружило проблемы: разные результаты в разных частях штата, которые невозможно было объяснить. И в-третьих, наши эксперты обнаружили фундаментальные статистические ошибки в структуре самой формулы».

Эппника спросили, как так вышло, что Medicaid продолжал пользоваться программой, несмотря на то, что она была совершенно нерациональна. «Не думаю, что они сами знали, насколько всё было плохо. У всех людей есть этот предрассудок по поводу компьютерных ответов: мы в них не сомневаемся. Это культурное, может, даже биологическое: когда компьютер что-то выдаёт или когда статистик смотрит на данные и придумывает формулу, мы склонны доверять этой формуле, не спрашивая, как она на самом деле работает. Думаю, штат оказался жертвой этой удовлетворённости компьютерными решениями. Кроме того, я не думаю, что кто-то внутри Medicaid знал, как это вообще работает. Когда мы попросили каждого участника программы объяснить, как работала формула и как были получены оценки, все кивали друг на друга: „Я не знаю, но вон этот знает“. В конце концов оказалось, что мы ходим по кругу. Проблемой было то, что никто не понимал весь процесс целиком, но все предполагали, что кто-то другой знал, как процесс работает».

Исследования сами по себе недешёвые, и ACLU считает, что компании по собственному желанию не станут нести издержки для проверки своих моделей, если никто не станет их заставлять это сделать в судебном порядке, как вышло в Айдахо. ACLU продолжает бороться, но индустрия в целом давно известна своей безответственностью, и практически все лицензии на программное обеспечение начинаются со слов «предоставляется как есть», а фраза «ответственности не несём» повторяется раз двести.

V БЕЗРАБОТИЦА

Внедрение машинного обучения будет всё активнее влиять на рынок труда: как квалифицированного, так и неквалифицированного. Да, машина может полностью заменить человека. Скажем, кассира, как это показано в рекламе Amazon Go: пользователь просто берёт продукты с полки и выходит из магазина, а деньги списываются автоматически. Другой интересный пример — автономные автомобили. Одна из конечных целей «Убера», о которой компания заявляет давно и открыто, — замена всех водителей на собственный парк автономных машин. Автоматизированы будут не только низкооплачиваемые работы (Обама в экономическом отчёте перед конгрессом в 2016 году заявил, что у тех, кто зарабатывает меньше 20 долларов в час, есть шанс в 83 % быть заменёнными компьютером). Работники хедж-фондов с зарплатами в 300 000 долларов в год тоже будут автоматизированы. Многие миллионы людей потеряют работу (только в США — три с половиной миллиона водителей), создавая новый класс «бесполезных» — как пишет Юваль Ной Харари в своей книге «Сапиенс: Краткая история человечества» — людей. Даже в противоположность страдающему, но иногда работающему прекариату, этот класс в принципе не сможет найти никакой работы и будет вынужден полагаться на помощь государства. При этом будет происходить постепенное ухудшение положения низших слоёв общества: сначала переход к gig-экономике (по принципу Uber, Airbnb, TaskRabbit и прочих компаний, якобы работающих с партнёрами, чтобы избежать налогов и выплат для настоящих сотрудников) с потерей прав и привилегий наёмных работников — а потом и вовсе выпадение из неё по мере дальнейшей автоматизации.

Специфика тренировки моделей машинного обучения на данный момент создаёт новые рабочие места не только для инженеров, но и для низкооплачиваемых взаимозаменяемых временных работников: Wired недавно писали о невыносимых условиях труда сотрудников Google, оценивающих контент на YouTube. Однако оценщики будут нужны только до того момента, когда будет накоплено достаточно данных, чтобы машина смогла автоматически сортировать контент. После этого её будет обслуживать очень небольшое количество квалифицированных инженеров, а оценщики будут уволены.

Массовая потеря работы уже даже не на производстве, а в секторе обслуживания очевидным образом создаёт проблемы для капиталистической системы, утверждают экономисты самых разных школ. Согласно данным Банка Англии, в течение следующих десяти-двадцати лет будут автоматизированы восемьдесят миллионов американских и шестнадцать миллионов британских рабочих мест — а это половина всех рабочих мест обеих стран. Неизбежно усилится социальное расслоение, увеличится разница в доходах между богатыми и бедными и понизится социальная мобильность. Многие экономисты, философы и социологи пытаются представить будущее без работы; пока не ясно, как изменятся общественные отношения и общественное сознание, поскольку для многих работа всё ещё является основой самоидентификации и самореализации, а также основой экономического устройства общества.